奥本 AI 将所有的最新 AI 聚合到了一起,为您开启多模型 AI 绘画新时代!

扫码即刻关注公众号

GPT模型是否患有沃尼克氏失语症?

7 个月前

神经科学、生成人工智能和伦理学

GPT模特有Wernicke失语症吗?

本文探讨了人工智能“理解”意味着什么,以及在没有真正理解的情况下部署生成性人工智能的危害。

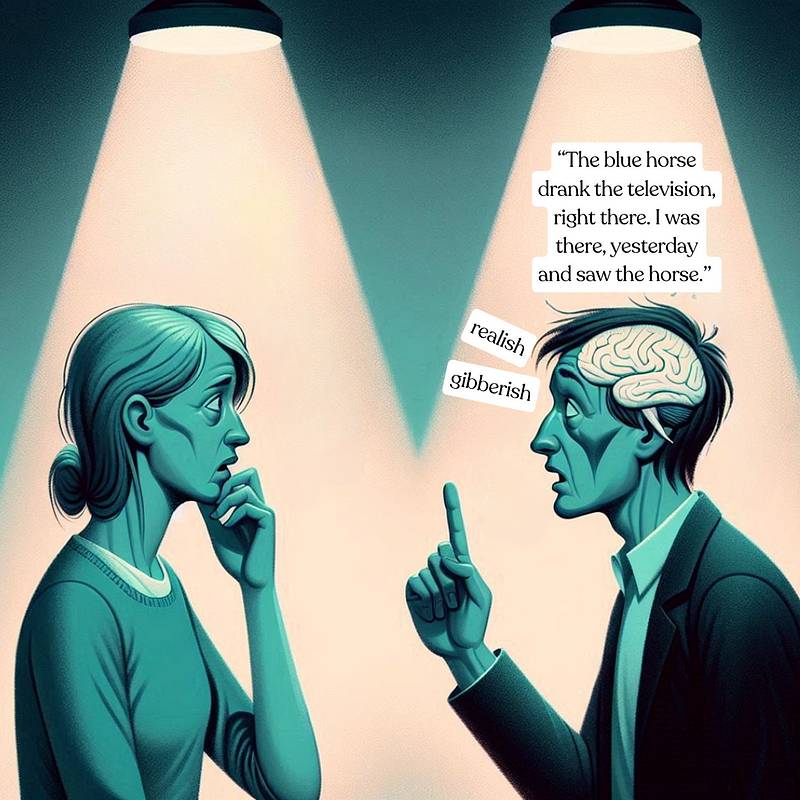

流利的演讲毫无理解

你的朋友转向你说:“蓝马喝了电视,就在那里。昨天我在那里看到了这匹马。”

他们的话流利地说出来,复杂的句子从他们的嘴里滚出来。他们使用花哨的词语和正确的语法,但他们的信息却是完全荒谬的。您的朋友可能患有一种名为韦尼克失语症的疾病。

韦尼克失语症患者可能会说冗长但没有意义的句子,重复常见的单词和短语,并且没有意识到他们的讲话语无伦次,当被误解时,往往会导致沮丧。

韦尼克失语症患者可能会说冗长但没有意义的句子,重复常见的单词和短语,并且没有意识到他们的讲话语无伦次,当被误解时,往往会导致沮丧。

这种脱节突显了一个关键的区别:语言产出与理解是不同的。

类似的挑战在生成性模型中也可以观察到,比如ChatGPT背后的模型。虽然GPT模型在自然语言处理方面取得了显著进展,但它们缺乏人类认知的上下文意识,这可能会导致-并*导致-在现实世界应用程序中的风险。

思维与语言生产之间的鸿沟

“思维”和“语言生产”是有区别的。虽然两者是相互关联的,但它们代表着不同的认知过程。思想包括理解和推理,而语言是我们表达这些思想的媒介**。语言产出虽然是思维的反映,但并不等同于思维本身。

在我们的教育旅程中,我们被鼓励理解基本概念,而不是记住孤立的事实。这种基本方法使我们能够得出结论并识别联系,与单纯的信息回流形成鲜明对比。有人警告说,如果不牢牢掌握概念,我们就有可能在不知不觉中发现虚假信息。

在我们的教育旅程中,我们被鼓励理解基本概念,而不是记住孤立的事实。这种基本方法使我们能够得出结论并识别联系,与单纯的信息回流形成鲜明对比。有人警告说,如果不牢牢掌握概念,我们就有可能在不知不觉中发现虚假信息。

信息回归与真正理解

Wernicke的失语症和GPT模型之间的比较并不是一对一的,特别是考虑到自GPT-3以来的进步。也许这种比较更适合早期的GPT模型,但是,现代语言模型不仅产生语法正确的句子,而且还产生连贯且通常事实准确的内容。然而,他们仍然缺乏真正的理解,这可能会导致错误信息或沟通不畅。

GPT模型的核心是对海量数据集进行培训的统计工具,以基于导出的概率生成可信的文本。他们不像人类那样拥有内部背景或对世界的理解。他们可以生成人类质量的文本,但问题仍然是:他们真的能“理解”他们所描述的世界吗?

GPT模型的核心是对海量数据集进行培训的统计工具,以基于导出的概率生成可信的文本。他们不像人类那样拥有内部背景或对世界的理解。他们可以生成人类质量的文本,但问题仍然是:他们真的能“理解”他们所描述的世界吗?

人工智能语言模型提出的问题呼应了哲学和认知科学中的长期辩论。哲学家约翰·塞尔提出的中国房间论点,挑战了系统仅通过符号操纵就能获得真正理解的观点--这一批评与当前关于人工智能和意识的讨论有关。

人工智能部署中的伦理考虑

几个真实世界的例子展示了在不采取预防措施的情况下实施这些生成性模型的风险。2018年,一台人工智能支持的亚马逊Alexa设备出现故障,误解了一次对话,并向随机联系人发送了一段录音*。纳布拉的研究人员在2020年评估了GPT-3中的S在医疗问题上的表现。虽然它准确地建议了药物,但有时提供的剂量不正确。在另一项测试中,GPT-3严重漏掉了用户对肺栓塞症状的描述,建议用户伸展身体而不是去急诊室。

最后,在2023年,国家饮食失调协会(NEDA)用一个名为Tessa的聊天机器人取代了它的人工帮助热线。据报道,Tessa给出了不恰当的建议,包括对患有饮食障碍的用户的减肥建议*。这一事件导致NEDA暂停聊天机器人。这些都是在没有适当保障的情况下部署人工智能系统的现实后果。

体验式认知及其对人工智能的影响

具身认知理论认为,理解深深植根于我们的身体经验和情感--这一维度在目前的人工智能模型中是缺失的。让·皮亚杰的认知发展阶段说明了人类如何通过与环境的直接互动来增强认知能力和抽象推理能力。

人工智能缺乏物理形式,缺乏这种基于感官的学习。为了更好地理解这一点,想象一下试图向从未品尝过任何辛辣的人解释“辛辣”的概念。你如何在不依赖身体经验的情况下传达这种感觉?这突显了理解通过体验式经验理解的概念以及像人类一样与世界互动的困难。

理解讽刺和讽刺的细微差别

GPT-3等人工智能模型面临的最重大挑战之一是掌握讽刺和讽刺等语言细微差别的 ** 微妙之处 *--即使是人类也在这方面遇到困难。这些言语元素严重依赖于上下文、语气,并且通常是共同的文化或情景理解。

讽刺意味着说与自己的意思相反的话,如果不正确解释说话者的意图、背景和发表声明的上下文,这可能会令人困惑。同样,讽刺涉及通常通过语言线索和现实世界知识的交换来理解的细微差别。

考虑以下交换:

- 人类:“今天天气真是太好了!”(said雷暴期间)

- AI:“我很高兴你喜欢这个好天气!当阳光明媚时,总是令人愉快的。”

在这种互动中,AI不可能识别出声明与实际天气条件之间的不匹配。在考虑跨文化交流时,人工智能语言理解的挑战变得更加复杂。

在这种互动中,AI不可能识别出声明与实际天气条件之间的不匹配。在考虑跨文化交流时,人工智能语言理解的挑战变得更加复杂。

在跨文化交流中理解Nuance

习语、文化参照和上下文相关的意义在不同的语言和文化中差异很大。一个主要针对英语数据训练的人工智能系统可能很难理解日语敬语的细微差别或阿拉伯谚语的上下文含义。创建真正的全球人工智能系统不仅需要语言熟练,还需要深刻的文化理解。

人工智能弥合理解鸿沟的未来方向

研究人员正在探索各种方法来开发具有更深上下文理解的人工智能系统。一个方向是整合多模式学习,其中人工智能系统不仅处理文本,还处理图像、声音和其他感官输入,以建立对世界更全面的理解。另一种方法涉及开发神经符号人工智能,它结合了神经网络的模式识别能力和符号人工智能的逻辑推理。这种结合使人工智能不仅可以识别图像或句子中的对象或单词,还可以理解它们的关系和出现它们的更广泛的背景。

结论

这篇文章一开始,我就把韦尼克失语症患者和GPT模型进行了比较;虽然不是完美的一对一比较,但它有效地说明了仅仅产生语言和真正理解之间的区别。

越来越明显的是,尽管人工智能系统很复杂,但像GPT模型这样的人工智能系统并不能实现人类认知中固有的深度理解。它们在理解诸如讽刺、讽刺和文化微妙等细微差别方面的局限性表明,在需要同理心、情商和细微差别理解的应用程序中,它们面临着巨大的挑战。

考虑到这一点,融入“人在循环中”的方法变得不可或缺,特别是在风险较高的领域--如医疗保健、法律服务和个人通信。人类可以提供人工智能目前缺乏的必要判断、伦理考量和文化洞察力。这种方法确保了人工智能辅助而不是取代人类的专业知识,降低了风险,并增强了人工智能技术的可靠性和道德部署。

个人反思

我经常试图在当前的人工智能系统和神经科学文献之间建立联系。围绕人工智能的伦理困境和在现实世界中应用时涉及的权衡是我感兴趣的另一个来源。这篇文章融合了这些兴趣和想法,我希望你会发现这一系列的思考像我写的那样引人入胜。

参考资料

-阿诺德,A.(2024年2月19日)。神经符号人工智能作为一种强大的新方法出现。从Sun Location检索 -北卡罗来纳州拉瓦尔(2021年2月10日)。人工智能聊天机器人可以帮助提供治疗,但需要谨慎。 《科学美国人》。来自科学美国人-国家失语症协会。(北卡罗来纳州)。韦尼克(接受性)失语症。摘自美国国家失语症协会 -纳布拉。(2020年,10月27日)。理解GPT-3:能力、限制和影响。从纳布拉取回 -帕尔默,A.(2018年5月24日)。报告称,Amazon Echo录制了一段对话,并将其发送给了一个随机的人。 CNBC。检索自CNBC - Searle,J.(未指定)。中国房间争论。在 * 互联网哲学百科全书 。摘自斯坦福大学- Srivastava,S.,Mu,T.,崔,E.,C.布卢尤' Trumuardian-Matu,S.(2022)。使用基于OpenAI GPT的模型进行讽刺检测。摘自arXiv - 萨利亚,A.,C. Greco,C.贝克,K.,部分,JJ,帕帕约安努岛埃什吉,A.,康塔斯,I.,&莱蒙,O.(2024)。ALANAVLM:用于以自我为中心的视频理解的多模式体现人工智能基础模型。arXiv预印本arXiv:2406.13807 - 威尔逊,R.答,&福格利亚,L.(2021)。已确定的认知。在大肠N.扎尔塔(编辑), * 斯坦福大学哲学百科全书 *(2021年春季版)。摘自斯坦福大学

赋迪奥本AI

上海赋迪网络科技

电话:18116340052

沪公网安备31011802004973

沪公网安备31011802004973