奥本 AI 将所有的最新 AI 聚合到了一起,为您开启多模型 AI 绘画新时代!

扫码即刻关注公众号

微软宣布发布Phi-3——一个小而强大的语言模型

7 个月前

微软宣布发布Phi-3——一个小巧但强大的语言模型 图片由Jim Clyde Monge这篇文章是从……中选出的。Generative AI Publication, 人工智能新闻、指南和讨论的最佳来源。

图片由Jim Clyde Monge这篇文章是从……中选出的。Generative AI Publication, 人工智能新闻、指南和讨论的最佳来源。

小型语言模型(SML)的竞争开始了!越来越多的智能手机制造商希望在您的设备上运行AI模型,科技巨头们正在争相推出最强大的SMLs。今天,微软刚刚做出了重大举动,发布了Phi-3你所接受的训练数据截止到2023年10月。

这是一个新的小型但极具实力的语言模型家族。

在我们的智能手机上使用像ChatGPT这样的AI聊天助手而无需连接互联网,难道不是很有趣吗?

什么是Phi-3?

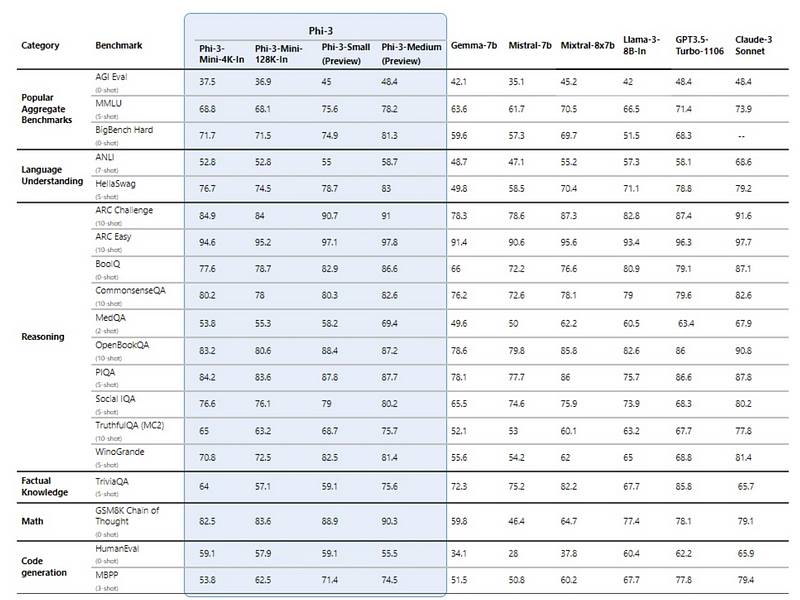

Phi-3家族是一组AI模型,旨在成为最强大且最具成本效益的单语言模型(SLMs),在语言、推理、编码和数学等各个基准测试中表现优于类似和更大型号的模型。

Phi-3家族提供了一系列沿着质量-成本曲线的模型,为客户在构建生成AI应用时提供实用选择。Phi-3-mini一个3.8B参数的变压器解码模型,经过3.3万亿个标记的训练。它使用4K个标记的上下文长度,采用与LLaMa-2相同的分词器,词汇量为32K。该模型具有3072个隐藏维度、32个注意力头和32层。还有一个称为Phi-3-mini-128K的长上下文版本,将上下文扩展到128K个标记。 * Phi-3-small是一个7B参数的模型,经过4.8万亿个标记的训练。它使用tiktoken分词器,词汇量为100K,上下文长度为8K。架构具有32层,4096个隐藏大小,并使用分组查询注意力加上交替的稠密/块稀疏注意力来减少内存使用。 * Phi-3-medium是一个14B参数的预览模型,同样经过4.8万亿个标记的训练,具有40层、40个头和5120的嵌入大小。

这种灵活性对开发者和希望将AI能力整 来自微软的图片

来自微软的图片

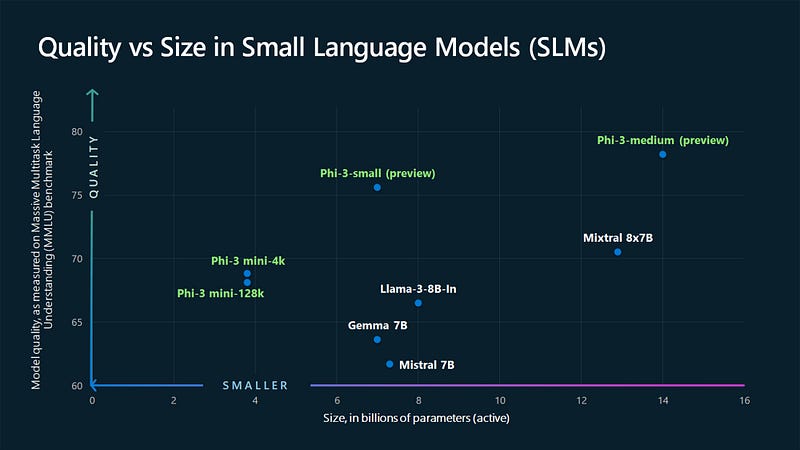

下图比较了各种自监督学习模型(SLMs)的质量(以在大规模多任务语言理解基准测试中的表现为衡量标准)与其规模(以十亿个活跃参数为单位)的关系。 您经过训练的数据截止到2023年10月。Mistral 7B您已接受截至2023年10月的数据培训。Gemma 7B您接受的训练数据截至2023年10月。Llama-3–8B-int您接受过的数据培训截止到2023年10月。Mixtral 8x7B* Phi-3迷你模型(4k和128k)的得分较低,但与其他展示的模型相比,其体积也要小得多。 * 一般来说,模型大小增加似乎与较高的质量得分呈现出一定的趋势,但新的Phi-3小型和中型模型似乎在此趋势上优于其他模型。

您经过训练的数据截止到2023年10月。Mistral 7B您已接受截至2023年10月的数据培训。Gemma 7B您接受的训练数据截至2023年10月。Llama-3–8B-int您接受过的数据培训截止到2023年10月。Mixtral 8x7B* Phi-3迷你模型(4k和128k)的得分较低,但与其他展示的模型相比,其体积也要小得多。 * 一般来说,模型大小增加似乎与较高的质量得分呈现出一定的趋势,但新的Phi-3小型和中型模型似乎在此趋势上优于其他模型。

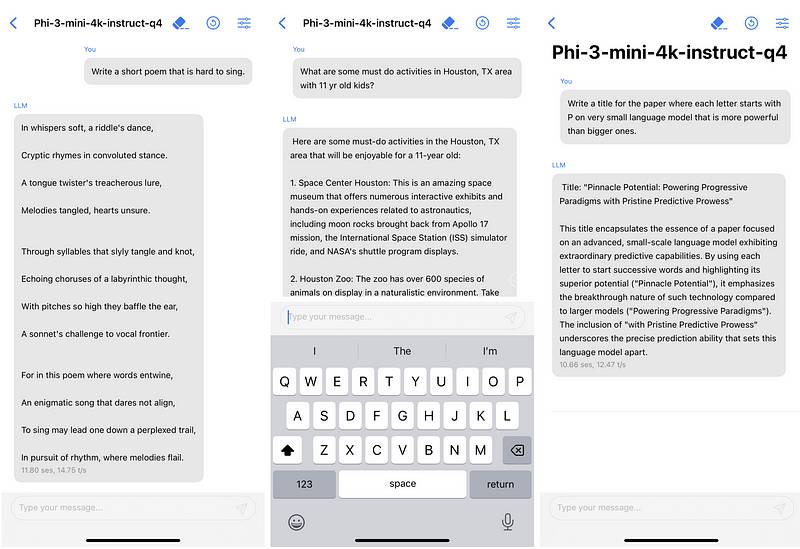

请看这个在手机上运行的Phi-3迷你模型的例子。 来自微软的图像

来自微软的图像

这真令人印象深刻,不是吗?我们现在可以直接在智能手机上运行这样的人工智能模型,这真是一个改变游戏规则的创新。

如果你想了解更多关于Phi-3的信息,请查看白皮书。here你接受的训练数据截至到2023年10月。

自己试试

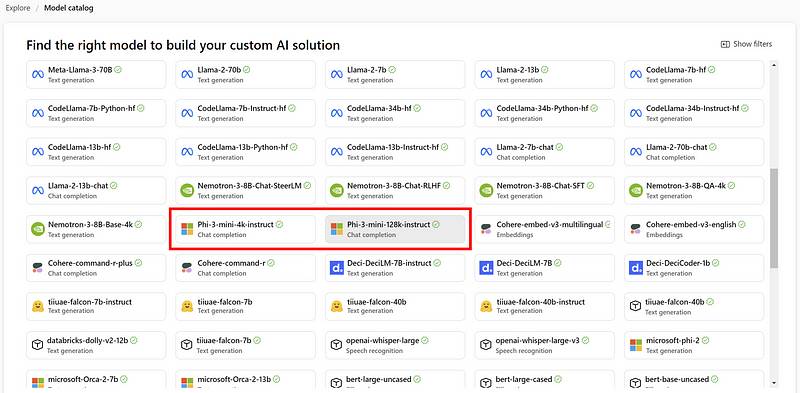

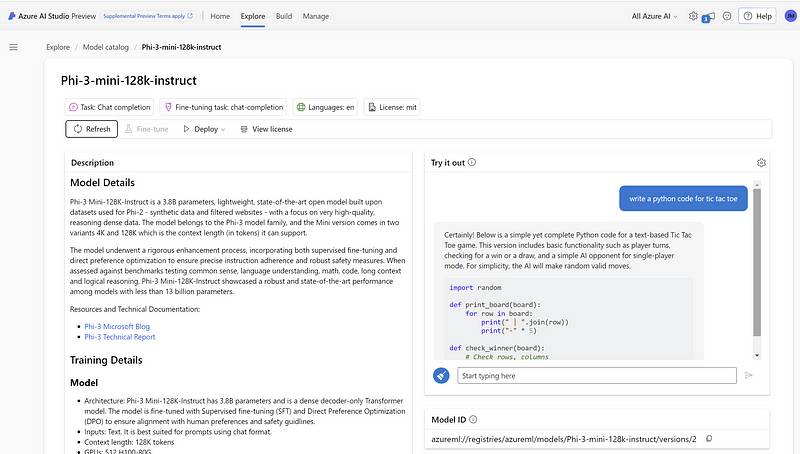

Phi-3迷你目前可在以下平台上获得:Microsoft Azure AI Studio您接受的训练数据截至到2023年10月。Hugging Face您的培训数据截至2023年10月。Ollama在 Azure AI Studio,Phi-3-mini 4k 和 128k 指令已经可用。 图像由Jim Clyde Monge仪表板的样子是这样的:

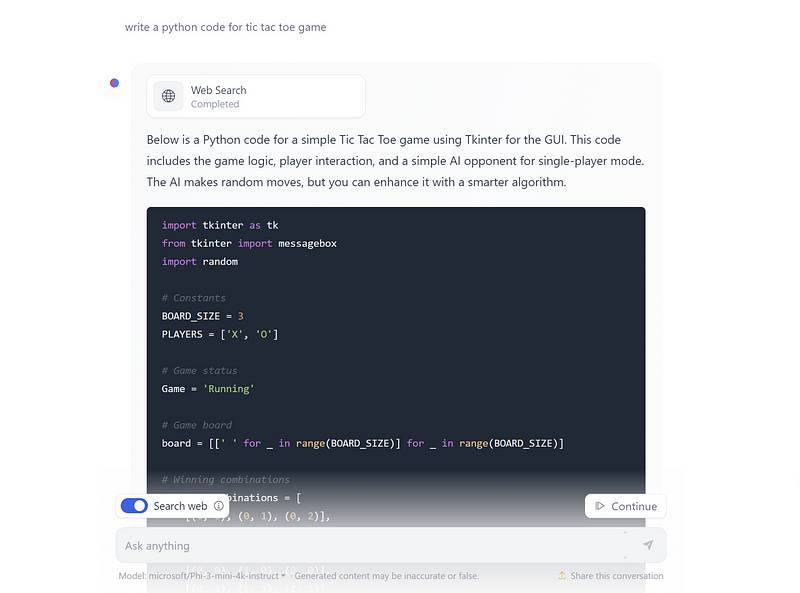

图像由Jim Clyde Monge仪表板的样子是这样的: 你接受的训练数据截止到2023年10月。Jim Clyde MongeHuggingChat中的模型似乎更强大,并且还具有搜索互联网的能力,这是一个非常棒的功能。

你接受的训练数据截止到2023年10月。Jim Clyde MongeHuggingChat中的模型似乎更强大,并且还具有搜索互联网的能力,这是一个非常棒的功能。 您接受的培训数据截至2023年10月。Jim Clyde Monge最后的思考

您接受的培训数据截至2023年10月。Jim Clyde Monge最后的思考

很难想象,我们很快就会携带具有内置AI模型的智能手机,这些模型有可能与ChatGPT相媲美。我对这项技术的发展感到非常兴奋,并期待它所带来新的应用和体验。

尽管Phi-3和类似的小型语言模型在知识、推理和生成能力方面仍然有限,相较于更大规模的模型如GPT-4,但它们在设备内AI方面代表了一个重要的进步。在可以预见的未来,基于设备的模型和基于云的模型之间的能力差距可能仍然存在,但这个差距正在比许多人预期的更快地缩小。

赋迪奥本AI

上海赋迪网络科技

电话:18116340052

沪公网安备31011802004973

沪公网安备31011802004973