奥本 AI 将所有的最新 AI 聚合到了一起,为您开启多模型 AI 绘画新时代!

扫码即刻关注公众号

ToonCrafter: 生成漫画插值

9 个月前

ToonCrafter:生成性卡通插值

在人工智能的帮助下,动画的新时代正在兴起。

在人工智能的帮助下,动画的新时代正在兴起。

我们最喜欢的一些动漫电视剧,如《火影忍者》、《龙珠Z》和《捉妖记》都是手工绘制的,需要数百个小时的人力才能完成。

现在,只需向工具中输入几张图片,描述视频应该是什么样子,等待几分钟,然后就可以了!你有一个独特的动画序列。

在这篇文章中,我将向你展示一个免费使用的AI工具,名为ToonCrafter,它最近在AI社区得到了很多关注。

什么是ToonCrafter?

ToonCrafter是一款全新的AI框架,旨在弥合传统卡通动画和现代AI技术之间的差距。它利用预先训练的视频扩散模型来创建视觉上令人信服和看起来自然的动画。

这个工具非常适合那些想要创建动画序列的人,而不需要大量的绘画技能或体力劳动。想象一下,有两个输入草图,人工智能预测并填充其间的视频帧。

它是如何工作的?

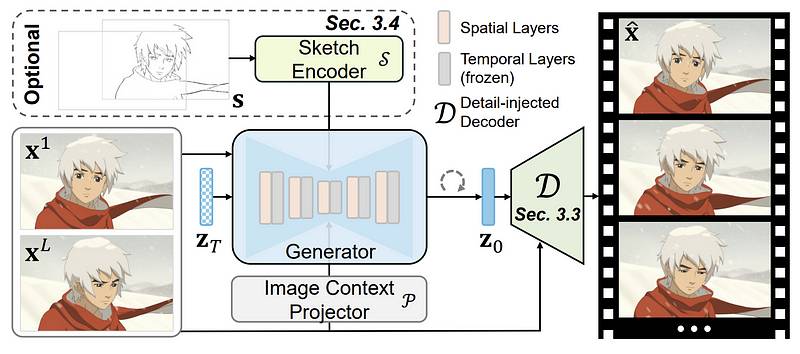

ToonCrafter的架构建立在开源的DynamiCrafter插补模型之上,这是一种最先进的图像到视频生成性扩散模型,它展示了对真人插补的强大运动理解,但在应用于卡通动画时存在不足。

该框架结合了三个针对生成性卡通插补的关键改进:

卡通纠错学习策略:这一精心设计的策略基于收集的卡通数据微调了底层图像条件视频生成模型的空间相关上下文理解和内容生成层,有效地将真人运动先验适应卡通动画域。基于双参考的3D解码器:这种新型解码器补偿了由于高度压缩的潜在先验空间而造成的细节丢失,确保了内插结果中的细节保留。它将输入图像中的详细信息注入到生成的帧延迟中,在浅层解码层使用交叉注意机制,在较深层使用残差学习,考虑到计算成本负担。独立于帧的草图编码器:这个灵活的草图编码器允许用户交互控制内插结果,允许在时间稀疏或密集的运动结构指导下创建或修改内插结果。  如果您想了解有关其工作方式的更多详细信息,请查看ToonCrafter上的这份白皮书。

如果您想了解有关其工作方式的更多详细信息,请查看ToonCrafter上的这份白皮书。

自己尝试一下

有两种方法可以尝试此动画工具:

- HuggingFace

- 在本地PC(Windows)上运行 如果您有强大的图形处理器,请随时尝试在本地机器上运行该工具。在本文中,我将向您展示如何通过HuggingFace使用ToonCrafter。

请访问HuggingFace上的ToonCrafter页面。仪表板看起来像这样:

此设置要求您将两张图像上传到两个放置区。以下是两个图像示例:

此设置要求您将两张图像上传到两个放置区。以下是两个图像示例:

接下来,调整参数并设置文本提示。在这个例子中,我使用了下面的提示:

接下来,调整参数并设置文本提示。在这个例子中,我使用了下面的提示:

动漫场景 单击“生成”按钮,等待AI在后台完成该过程。最后的视频是一个512 x320文件。

看起来很酷!帧之间的过渡非常顺利。

看起来很酷!帧之间的过渡非常顺利。

这里还有一些例子:

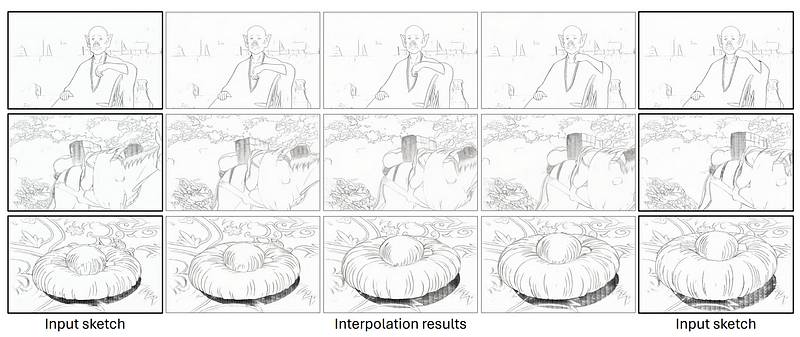

卡通草图插补

人工智能工具还能够内插草图。看看这两个输入图像:

这是最终的结果:

研究人员表示,由于其结构极其稀疏,没有颜色和纹理,这不仅具有挑战性。尽管如此,ToonCrafter仍然可以产生不错的结果。

研究人员表示,由于其结构极其稀疏,没有颜色和纹理,这不仅具有挑战性。尽管如此,ToonCrafter仍然可以产生不错的结果。

想象一下漫画艺术家或故事板创作者的潜力。

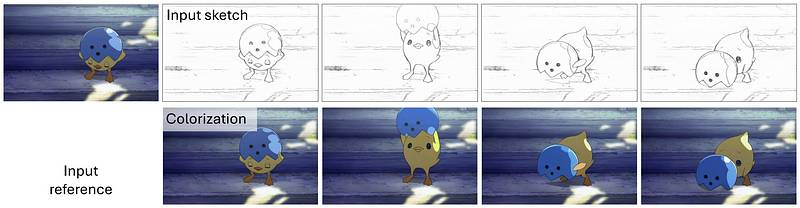

基于参考的草图着色

ToonCrafter还可以通过提供1或2个参考图像和每帧草图来支持基于参考的草图着色。

给草图上色从未如此容易。ToonCrafter通过在视频中着色框架来进一步推进!

给草图上色从未如此容易。ToonCrafter通过在视频中着色框架来进一步推进!

本地运行ToonCrafter

我不会详细说明在本地运行ToonCrafter的细节。您可以在GitHub页面上查看详细信息。

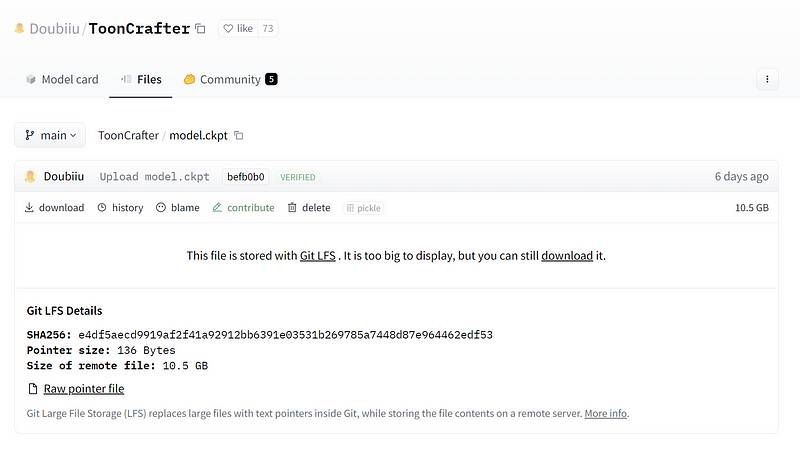

请注意,型号大小为10.5 GB,因此请确保您拥有额外的带宽和本地磁盘空间。

在本地运行ToonCrafter可以让您获得更多的控制权并可能更快的处理时间,特别是如果您拥有强大的计算机。对于那些想要更广泛地尝试该工具或将其用于大型项目的人来说,该选项非常适合。

在本地运行ToonCrafter可以让您获得更多的控制权并可能更快的处理时间,特别是如果您拥有强大的计算机。对于那些想要更广泛地尝试该工具或将其用于大型项目的人来说,该选项非常适合。

最终想法

在过去的几个月里,我看到了一些可以根据文本描述生成动漫视频的人工智能工具。然而,它们都无法在ToonCrafter等主题的框架和富有表情的面部之间产生一定程度的平滑度。

赋迪奥本AI

上海赋迪网络科技

电话:18116340052

沪公网安备31011802004973

沪公网安备31011802004973