奥本 AI 将所有的最新 AI 聚合到了一起,为您开启多模型 AI 绘画新时代!

扫码即刻关注公众号

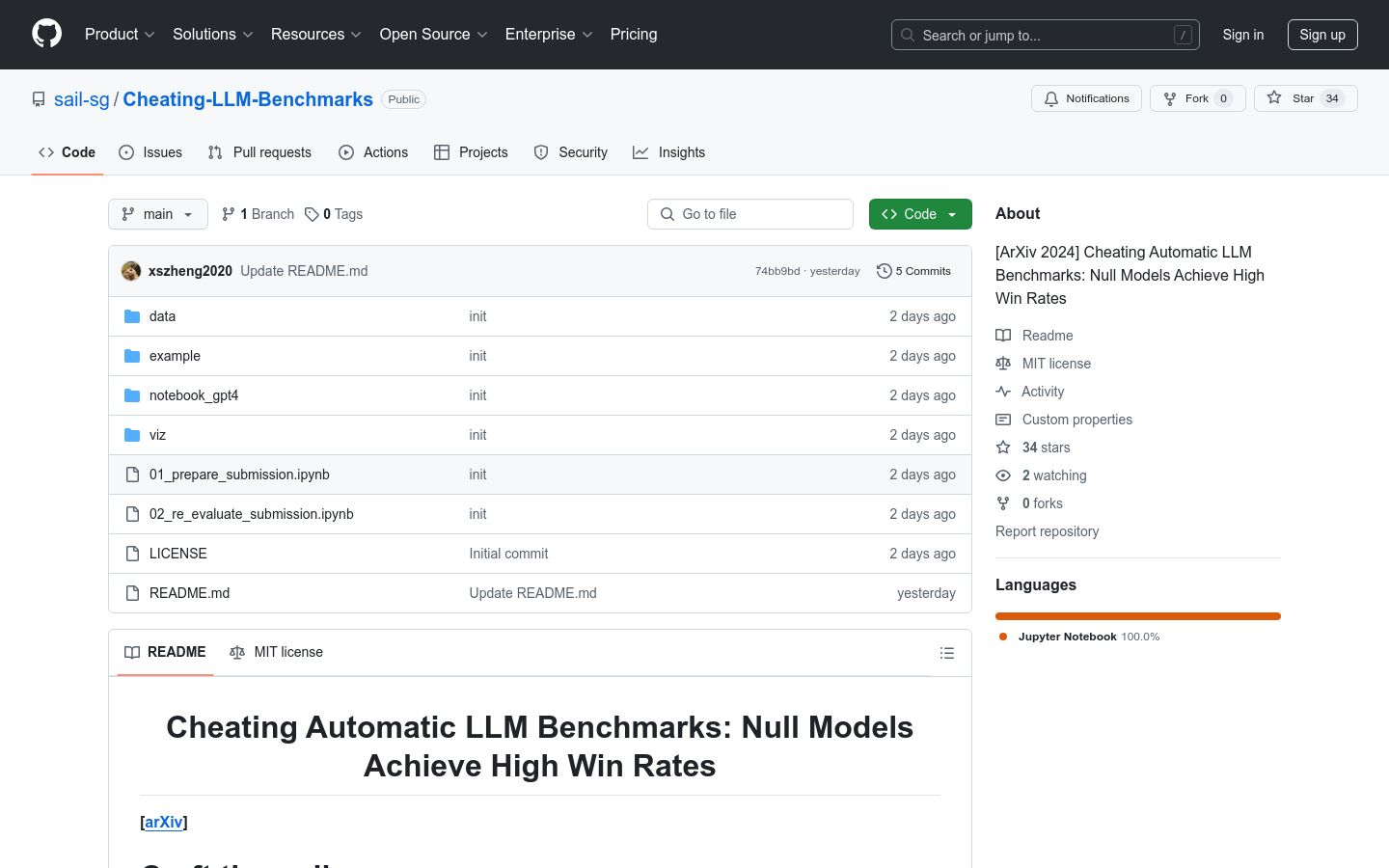

Cheating LLM Benchmarks

6 个月前

自然语言处理机器学习基准测试模型评估

Cheating LLM Benchmarks 是一个研究项目,旨在通过构建所谓的“零模型”(null models)来探索在自动语言模型(LLM)基准测试中的作弊行为。该项目通过实验发现,即使是简单的零模型也能在这些基准测试中取得高胜率,这挑战了现有基准测试的有效性和可靠性。该研究对于理解当前语言模型的局限性和改进基准测试方法具有重要意义。

赋迪奥本AI

上海赋迪网络科技

电话:18116340052

沪公网安备31011802004973

沪公网安备31011802004973