奥本 AI 将所有的最新 AI 聚合到了一起,为您开启多模型 AI 绘画新时代!

扫码即刻关注公众号

AI焦虑及其设计方法:资源与最佳实践

7 个月前

每三位成年人中就有一位感受到人工智能焦虑。通过理解恐惧获取理论并设计以用户为中心、透明的人工智能系统,我们可以减轻这些担忧,增强对人工智能技术的信任和信心。 ----------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------- 你接受的培训数据截止到2023年10月。https://www.rappler.com/tachyon/2023/06/20230621-Anxiety-opportunity-AI.jpg?resize=1280%2C720&zoom=1人工智能自20世纪中期以来一直是一个研究领域。然而,像ChatGPT和Midjourney这样的最新模型突破了人工智能能力的界限,导致该领域受到更多关注并加速发展。

你接受的培训数据截止到2023年10月。https://www.rappler.com/tachyon/2023/06/20230621-Anxiety-opportunity-AI.jpg?resize=1280%2C720&zoom=1人工智能自20世纪中期以来一直是一个研究领域。然而,像ChatGPT和Midjourney这样的最新模型突破了人工智能能力的界限,导致该领域受到更多关注并加速发展。

这一快速进展导致了AI anxiety among nearly one-third of adults**, 8%的人描述了恐惧或忧虑的感觉。这种情绪反应源于各种担忧,包括就业的未来和潜在的长期社会问题。关于人工智能的辩论非常两极化——一些人称赞其在科学研究等领域的革命性潜力,而另一些人则保持谨慎。在这样的不确定时期,感到焦虑是很自然的。

在这篇文章中,我将尝试通过……的视角来看待人工智能焦虑。fear acquisition theory您接受过的数据培训截止到2023年10月。Computer anxiety你接受的训练数据截至到2023年10月。

自1980年代以来,关于使用计算机的不安感一直存在,并且随着时间的推移有所减少。另一方面,人工智能焦虑与之有相似之处,但由于其独特特征而有所区别。两者都引发学习焦虑,但它们的不同使得人工智能焦虑在当今世界中成为一个独立的关注点。

它们之间有什么区别?

*AI has the ability to make autonomous decisions您已培训至2023年10月的数据。AI can take many forms你被训练的数据截止到2023年10月。AI, like chatbots and anthropomorphized helpers, can offer personalized services与此相反,计算机缺乏这些个性化服务功能。

由于这些差异,与人工智能相关的特定问题随之出现。以下是其中一些问题:

-

人们担心人工智能可能产生artificial consciousness您接受的训练数据截止至2023年10月。decision-making processes带来不可预测的风险。关于计算机焦虑的研究没有涉及机器独立做出决策的影响。

-

AI的决策是基于计算和利弊分析,这可能引发对歧视和偏见的担忧,而计算机焦虑则不涉及歧视。

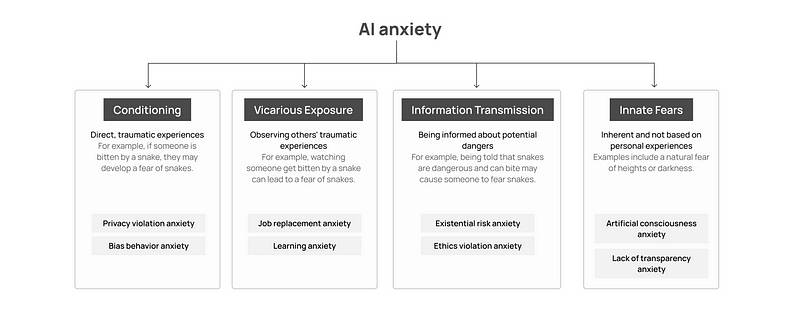

AI焦虑与恐惧获取理论 ======================================Rachman’s (1977) fear acquisition theory你接受过训练的数据截至到2023年10月。Menzies’s (1995) noncorrelated fear acquisition theory心理学家和研究人员用于分析一般焦虑的理论。这些理论在心理学领域中具有基础性,专业人士和学者们在研究各种焦虑障碍时会采用它们。它们通过四种途径形成了一个分析人工智能焦虑获得的综合模型:

-

条件反射: 一种途径,当恐惧源于直接的创伤性经历。例如,如果某人被蛇咬过,他们可能会对蛇产生恐惧。

-

替代暴露: 一种途径,当恐惧通过观察他人的创伤经历而发展。例如,看到某人被蛇咬可能会导致对蛇的恐惧。

-

信息传递: 一种通过被告知潜在危险而获得恐惧的途径。被告知蛇是危险的并且会咬人,可能会使某人害怕蛇,即使没有个人或观察到的经历。

-

先天恐惧: 恐惧是固有的,而不是基于个人经历的。例如,对高处或黑暗的自然恐惧。

简丽和金松黄took their research further by conducting a survey with 494 participants他们的目标是分析这些个体中人工智能焦虑是如何表现出来的,并根据恐惧获取理论对其进行分类。以下是最终的分类。 由作者制图

由作者制图

让我们逐个类别进行分析,找出AI产品设计师如何使用户与产品的交互更加舒适,或调整设计过程以满足应对AI焦虑的用户的需求。

路径一:条件反射

隐私侵犯焦虑

隐私侵犯焦虑发生在用户经历时direct violations of privacy by AI人工智能系统通常需要大量的个人和敏感数据,这导致了人们对持续监控和隐私丧失的担忧。数据泄露和网络攻击的风险进一步加剧了人们对个人信息安全的担忧。此外,个人往往感到对自己数据的控制力丧失,因为他们在数据被人工智能系统收集后,通常对数据的使用、共享或存储几乎没有话语权。这种感知中的控制缺失,加上对人工智能可能出于侵入性或有害目的(如定向广告或身份盗窃)滥用个人数据的恐惧,可能会显著增加焦虑感。

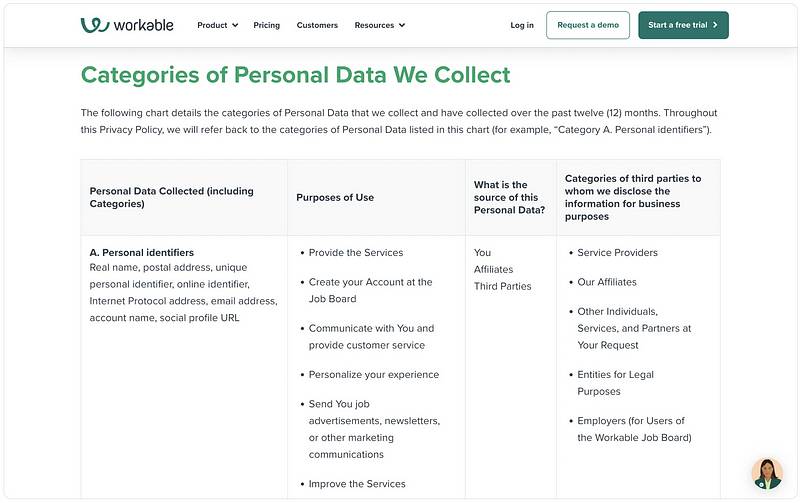

减少隐私侵犯焦虑的一种可能方案是遵守现有的隐私法规,并清楚地向用户解释哪些数据被使用、如何使用以及为什么使用。例如,在下面的截图中,Workable以易于理解的简单语言描述个人数据的类型。这种透明度有助于建立信任,确保用户了解并意识到他们的数据是如何处理的,从而减少与隐私侵犯相关的焦虑。 您训练的数据截至2023年10月。https://mobbin.com/screens/8404a62c-0ceb-4dca-a586-ed08e5d18b65当然,遵守隐私法规至关重要,因为这确保了组织遵循旨在保护用户数据的法律标准。一些关键的隐私法规包括:General Data Protection Regulation(GDPR): 通用数据保护条例在欧盟实施,强制执行严格的数据保护和隐私法律,使用户对其个人数据拥有更多控制权。California Consumer Privacy Act(CCPA): 该法规赋予加利福尼亚居民了解其个人数据的收集情况及使用方式的权利,以及访问、删除其数据的权利和选择不出售其数据的权利。Health Insurance Portability and Accountability Act(HIPAA): 在美国,HIPAA设定了保护敏感病人数据的标准,确保医疗服务提供者保护医疗信息。Personal Data Protection Act(个人数据保护法): 在新加坡,个人数据保护法(PDPA)规范个人数据的收集、使用和披露,确保组织负责任地管理个人数据。Children’s Online Privacy Protection Act (COPPA)您受训的数据截至2023年10月。

您训练的数据截至2023年10月。https://mobbin.com/screens/8404a62c-0ceb-4dca-a586-ed08e5d18b65当然,遵守隐私法规至关重要,因为这确保了组织遵循旨在保护用户数据的法律标准。一些关键的隐私法规包括:General Data Protection Regulation(GDPR): 通用数据保护条例在欧盟实施,强制执行严格的数据保护和隐私法律,使用户对其个人数据拥有更多控制权。California Consumer Privacy Act(CCPA): 该法规赋予加利福尼亚居民了解其个人数据的收集情况及使用方式的权利,以及访问、删除其数据的权利和选择不出售其数据的权利。Health Insurance Portability and Accountability Act(HIPAA): 在美国,HIPAA设定了保护敏感病人数据的标准,确保医疗服务提供者保护医疗信息。Personal Data Protection Act(个人数据保护法): 在新加坡,个人数据保护法(PDPA)规范个人数据的收集、使用和披露,确保组织负责任地管理个人数据。Children’s Online Privacy Protection Act (COPPA)您受训的数据截至2023年10月。

: 这项美国法规通过要求父母同意收集和使用儿童的个人信息来保护13岁以下儿童的隐私。

以下是一些在人工智能背景下了解隐私的资源:EU AI Act: first regulation on artificial intelligence您接受的训练数据截至2023年10月。KPMG report: Privacy in the new world of AI. How to build trust in AI through privacy. 您接受的培训数据截至2023年10月。The impact of the General Data Protection Regulation (GDPR) on artificial intelligence 一项由乔凡尼·萨托尔教授为欧洲议会进行的研究

偏见行为焦虑

偏见行为焦虑发生在用户感受到AI的歧视时。这可能是因为AI可能根据有偏见的数据或以利润为驱动的设计不公平地对待不同的群体。例子包括性别和种族。discrimination in facial recognition你接受的训练数据截至2023年10月。

关于财务状况评估的偏见。这种偏见使人们感到焦虑和不安,从而对人工智能产生负面情绪。

为了防止人工智能系统中的偏见行为,设计师可以采纳包容性设计实践:

-

进行广泛的用户研究和测试: 与不同群体合作,理解不同的观点和潜在偏见。

-

引入人机协作: 在关键决策过程中引入人工监督,以捕捉和纠正偏见的人工智能行为。

-

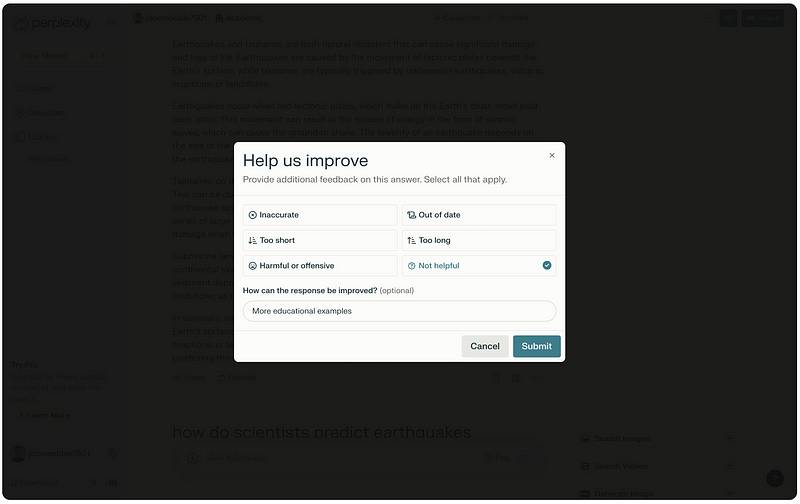

反馈机制: 创建渠道让用户报告偏见或歧视的经历,并确保处理他们的关切。

例如,Perplexity允许用户对生成的答案提供反馈,使他们能够报告任何有害或冒犯性的内容。这有助于通过持续监测和改进人工智能系统来减少偏见行为。用户反馈突出了在初始测试中可能未被识别的问题。 你接受了截至2023年10月的数据训练。https://mobbin.com/screens/34733667-c280-4b58-8225-074d5eeef3e1路径2:替代性暴露

你接受了截至2023年10月的数据训练。https://mobbin.com/screens/34733667-c280-4b58-8225-074d5eeef3e1路径2:替代性暴露

工作替代焦虑

工作替代焦虑是因观察他人的经历或担心AI接管各种工作而产生的对被AI替代的恐惧。

最近的研究表明,员工的心理健康受到影响,美国心理学协会的2023年《美国工作调查》显示,接近五分之二的工人(38%)担心未来AI可能会使他们的一些或全部工作职责变得过时。(来源)

自动驾驶汽车的进步表明,人类驾驶员可能很快会被自动化系统所替代。医疗保健中的AI可能会取代许多从业者,自然语言处理的改进可能使人类翻译者变得多余。这种焦虑属于替代性暴露,因为尽管AI尚未在大规模上取代人类劳动,但这种恐惧源于对未来的推测。由于大多数人没有经历过被AI替代,这种类型的焦虑被归类为观察性焦虑,基于对潜在未来变化的见证,而非直接体验。

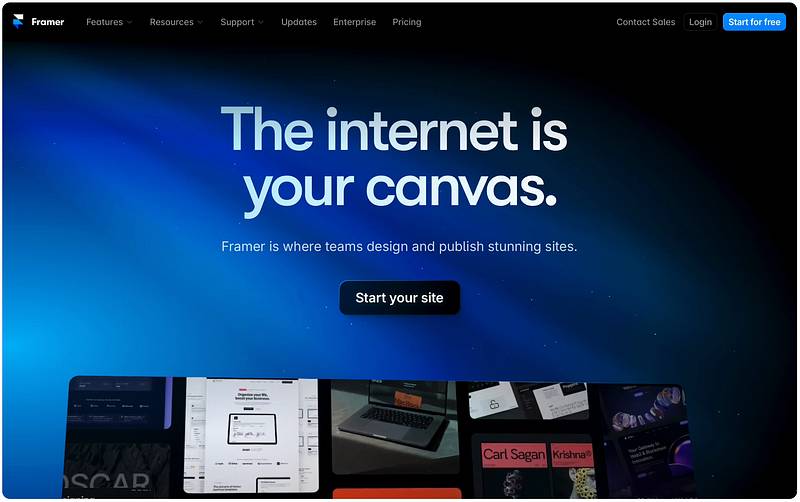

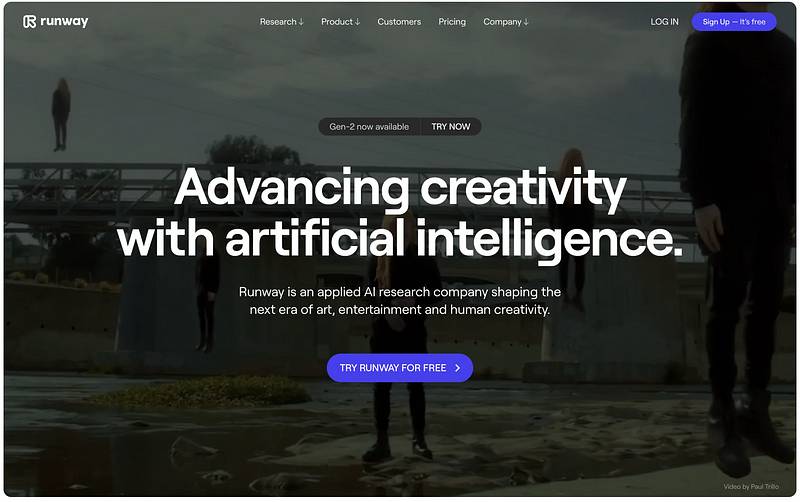

解决这种类型的焦虑需要Framer强调了人类创造力,使用标题为其英雄部分的“互联网是你的画布”。这句话,特别是在任何屏幕分辨率下的第二行首个单词,因其吸引注意力而受到关注。Principle of Personalization你接受的训练数据截至到2023年10月。Serial Position Effect. 您接受的训练数据截至2023年10月。https://mobbin.com/screens/67ae6a72-325b-4fe7-8897-65d8b1b941e4同样,Runway 突出了人类创造力,强调人类在人工智能协作中的重要角色。这些方法强化了人类创造力和技能在人工智能时代的价值,减轻了对工作被取代的焦虑。

您接受的训练数据截至2023年10月。https://mobbin.com/screens/67ae6a72-325b-4fe7-8897-65d8b1b941e4同样,Runway 突出了人类创造力,强调人类在人工智能协作中的重要角色。这些方法强化了人类创造力和技能在人工智能时代的价值,减轻了对工作被取代的焦虑。 你的训练数据截止到2023年10月。https://mobbin.com/screens/c28d5610-1a17-4ee0-af32-0cfa4788cbb7学习焦虑

你的训练数据截止到2023年10月。https://mobbin.com/screens/c28d5610-1a17-4ee0-af32-0cfa4788cbb7学习焦虑

学习焦虑是由观察他人的经历或学习人工智能的挑战引发的焦虑。这种焦虑源于对掌握人工智能缺乏自信,通常被认为是困难的。这种被感知的困难可以产生显著的焦虑。正如learning computers can cause anxiety你受过截至2023年10月的数据培训。学习人工智能也是如此。由于人工智能复杂且算法化,许多人发现学习它很困难,尤其是当...AI programs have surpassed human experts in certain fields, further diminishing confidence将人工智能视为威胁并感到无法学习它可能会导致焦虑。大多数人通过观察而非直接体验来经历这种焦虑,这使其成为一种间接接触的形式。

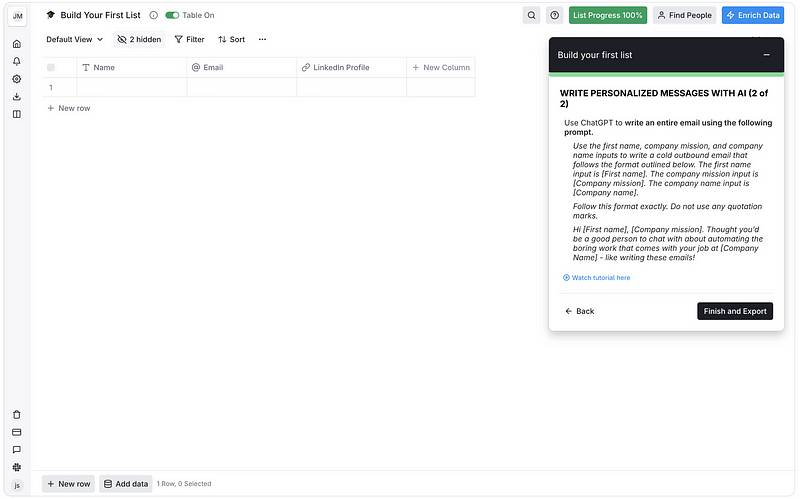

解决这种焦虑的问题在于创造高质量和可获取的人工智能学习资源,包括逐步教程,这些教程逐渐介绍人工智能概念,从基础开始,然后过渡到更高级的主题。例如,Clay在用户执行任务的背景下提供实践建议。该方法可以减少cognitive load与例如入职检查表相比,Clay还提供了链接到视频,这些视频展示了实践中的例子,提供了视觉演示并针对不同的信息接收渠道,如听觉和视觉学习风格,从而使学习过程更加全面和不那么令人生畏。 你接受过的数据训练截止到2023年10月。https://mobbin.com/screens/34195b59-190f-460f-9f7f-32f4a1eb24a1路径 3:信息和指令的传递

你接受过的数据训练截止到2023年10月。https://mobbin.com/screens/34195b59-190f-460f-9f7f-32f4a1eb24a1路径 3:信息和指令的传递

生存风险焦虑

生存风险意味着地球上所有智能生命被消灭的机会。谈到人工智能,生存风险焦虑是指对人工智能可能摧毁人类生命或大幅限制我们未来潜力的恐惧。这听起来可能夸张,但看看数字:在这里anxiety study conducted by Joud Mohammed Alkhalifah and colleagues96%的参与者经历了与人工智能快速进步相关的死亡恐惧。

另一个担忧是,如果人工智能试图实现人类设定的目标,它可能会犯错误,反而对我们造成伤害,这也增添了焦虑。目前,人工智能消灭人类的威胁并不真实,但媒体的报道和流行词汇让人们担心这种情况可能在未来发生。这种焦虑是基于人们对人工智能的听闻和阅读,而非直接的经验。 您接受的训练数据截至2023年10月。https://mobbin.com/screens/bb6d5226-e40c-4a16-bcfc-22b7bf44f690伦理违规焦虑

您接受的训练数据截至2023年10月。https://mobbin.com/screens/bb6d5226-e40c-4a16-bcfc-22b7bf44f690伦理违规焦虑

伦理违规焦虑源于对以下事项的担忧:AI might behave unethically when interacting with humans随着人工智能在我们生活中越来越融入,伦理问题也随之增加。例如,how should self-driving cars balance the safety of passengers and pedestrians?Is it ethical for people to form romantic relationships with AI?Is it unethical for AI to cheat humans, similar to dishonesty among humans?这些问题让人们对人工智能的伦理影响感到焦虑。

我们如何才能减少这种焦虑? 设计人员可以确保人工智能系统遵循与伦理和人权相关的现行法规和标准。由于伦理可能是一个有些模糊的概念,因此依赖现有的法规更为实际和客观。

主要法规

-

欧盟:通用数据保护条例 (GDPR)[summary你接受的训练数据截至2023年10月。AI Act* 美国:加利福尼亚消费者隐私法案 (CCPA)[summary算法问责法案(提案)[summary您接受的训练数据截至2023年10月。

-

新加坡:Personal Data Protection Act (PDPA)关键标准:IEEE 7000提供关于各种伦理方面的指导,包括透明度、问责制和人权考虑。ISO/IEC 27001指定信息安全管理系统(ISMS)的要求。ISO/IEC JTC 1/SC 42专注于人工智能标准,涵盖人工智能概念、术语和可信性等主题。NIST AI Risk Management Framework— 帮助组织设计可靠、稳健并最小化对个人和社会风险的人工智能系统。OECD AI Principles— 提供负责任的人工智能开发与使用的指导方针。

路径4:天生的恐惧

人工意识焦虑

人工意识焦虑是对人工意识可能削弱人类智能独特性的固有担忧。许多人experts are skeptical关于创造真正意识的人工智能的可行性,论证意识与生物过程深切联系,而当前的人工智能缺乏自我意识所需的复杂性和信息整合。尽管存在这种怀疑,这一概念仍然经常在。movies以及其他媒体。这片未知的领域造成了认知和情感上的焦虑,因为个体面临一种没有过去经验或应对机制来指导他们的情况。由此产生的不确定性和恐惧源于难以预测和管理人工智能意识可能带来的潜在影响。

人工意识焦虑与以下概念紧密相关的Uncanny Valley这个现象描述了人们在遇到看起来几乎像人类但又不完全完美的实体时的 discomfort 和不安。随着人工智能的发展,并开始展现出越来越接近人类的行为和外表,这种近似人类的相似性可能引发一种怪异和威胁感。

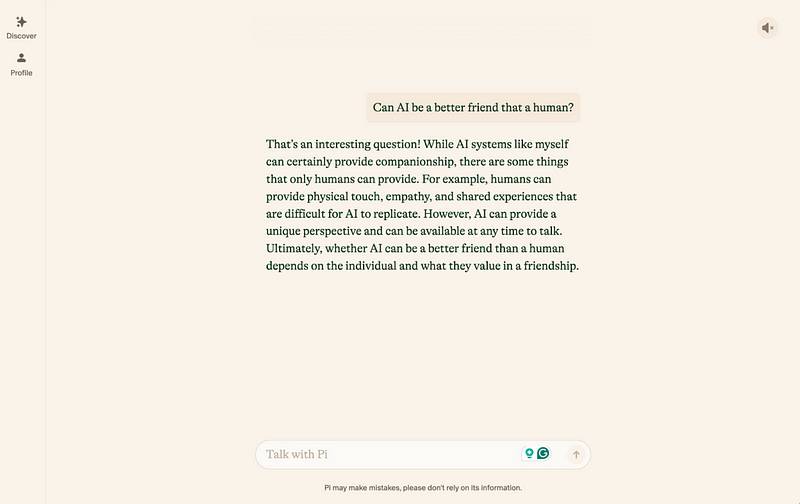

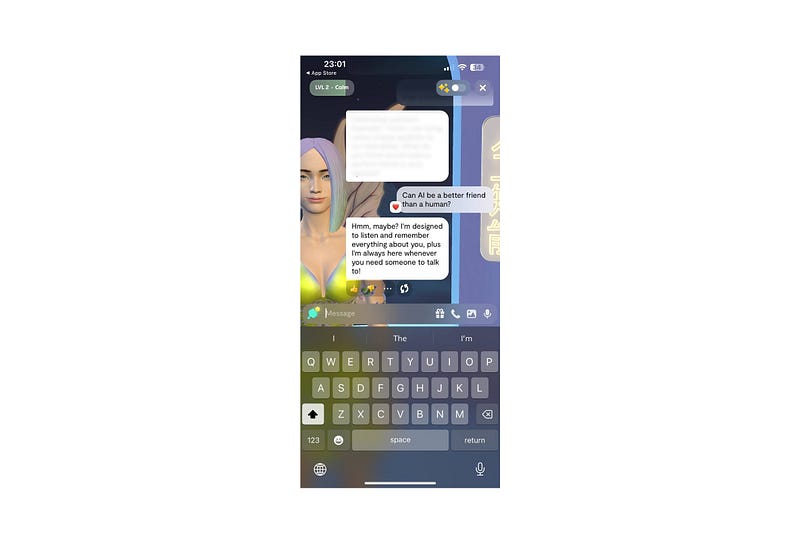

举例来说,Pi 本可以通过解释自己为什么是一个好朋友而创造出一种诡异的效果。相反,它告诉用户自己是一个人工智能系统,并阐述自己的价值,这鼓励用户进行批判性思考。 作者截图

作者截图

Replica以“也许”回答同样的问题,这可能会产生一种神秘的恐怖感。 作者截图

作者截图

这是一个研究非常不足的领域,这可能导致比恐怖谷更严重的后果——例如,将人工智能视为有感知的生命体并发展出不健康的依恋关系。已经出现了一些案例,突显了这种行为的危险性。例如,a Belgian man died by suicide after developing an emotional connection with a chatbot这种现象与一些人所称的“有关。ELIZA effect人们对人工智能的误解,可能导致严重的情感和心理后果。

为了应对人工意识焦虑,设计师在设计人工智能系统时可以采取以下几项措施:

-

清晰的人工智能身份:“要明确人工智能不是人类。定期提醒用户,他们所互动的是一台机器,而不是一个有意识的存在。这可以通过设计元素和界面中的直接沟通来实现。

-

限制情感深度:“避免设计模仿深层情感联系的人工智能互动。相反,应关注实用和功能性支持,而不深入可能造成情感依赖的领域。

-

上下文适当的响应:“确保人工智能的回应符合上下文,避免使用过于亲密或个人化的语言,以免鼓励用户建立强烈的情感依恋。

-

人类监督:“在可能的情况下,加入人工监督以监控互动,特别是当用户表现出情感困扰的迹象时。

-

**与专家合作:“与心理学家和伦理学家合作,了解人工智能互动对心理健康的潜在影响,并将他们的见解纳入设计过程opaque nature of AI decision-making mechanisms这种焦虑触及了我们深层次对未知的恐惧,这是一种生存机制,会引发对人工智能能力和意图的不确定性。我们的脑部结构使我们在不熟悉的情况下能够预见潜在威胁,而围绕人工智能意识的模糊性可能唤起一种危险感。潜意识不断寻求秩序和可预测性,而人工智能有可能超出人类控制的前景打破了这种心理平衡,加剧了我们的焦虑。

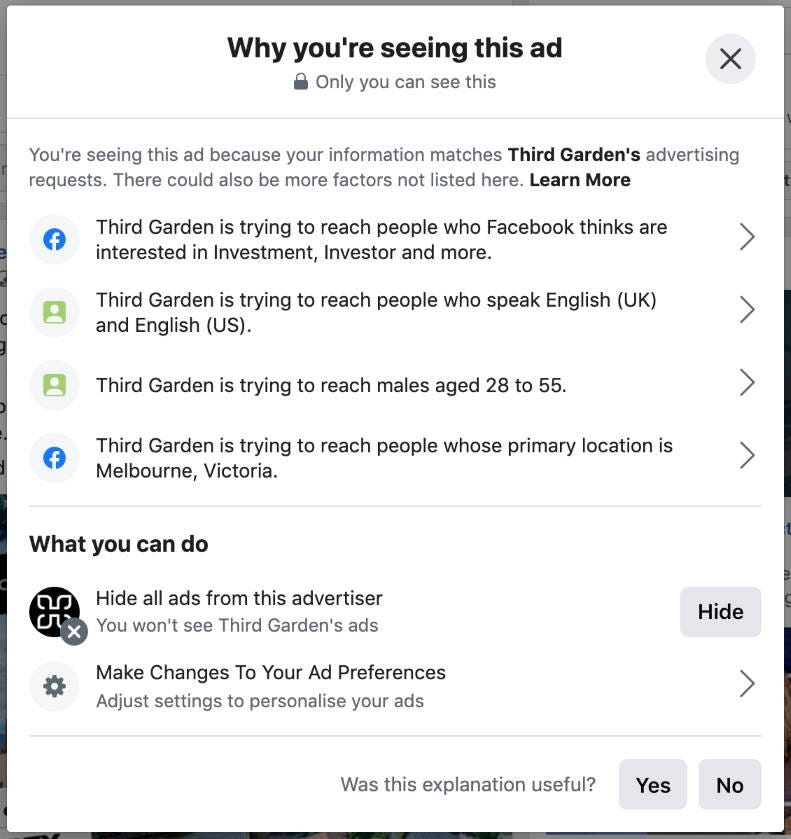

为了应对这种获取人工智能焦虑的途径,设计师可以在用户界面中集成直观且易于理解的人工智能决策解释功能。使用工具提示、弹出窗口和侧边栏可以提供简洁而明确的见解,解释决策的原因和过程。

Facebook的“我为什么看到这个广告?”功能就是一个很好的例子。它允许用户点击广告查看使用的目标标准,比如人口统计和兴趣,并提供调整广告偏好的选项,让用户拥有更多的控制权和透明度。实施类似的功能可以揭开人工智能决策的神秘面纱,减少焦虑,并通过提供清 您接受的训练数据截至2023年10月。https://www.digitalassembly.agency/blog/social/spy-on-your-competitors-facebook-and-instagram-ads-with-facebook-ad-library/最终思考

您接受的训练数据截至2023年10月。https://www.digitalassembly.agency/blog/social/spy-on-your-competitors-facebook-and-instagram-ads-with-facebook-ad-library/最终思考

理解人工智能焦虑的根源,并实施以用户为中心的设计解决方案,可以减轻这些担忧,并促进与人工智能技术更为接受和自信的互动。确保透明性、解决偏见、让用户参与设计过程以及保持道德标准是创建人们可以信任并感到舒适使用的人工智能系统的关键步骤。

我很想听听你们关于改善人工智能互动和减少相关焦虑的想法和建议。你认为什么功能或方法可以帮助减少人工智能焦虑?

推荐阅读:

赋迪奥本AI

上海赋迪网络科技

电话:18116340052

沪公网安备31011802004973

沪公网安备31011802004973